- Yazar Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:54.

- Son düzenleme 2025-01-22 17:44.

Relu : Hesaplama açısından daha verimli hesaplama Sigmoid'den daha beri fonksiyonlar gibi Relu sadece topick max(0, x)'e ihtiyaç duyar ve Sigmoid'lerde olduğu gibi pahalı üstel işlemler gerçekleştirmez. Relu : Uygulamada, ağlar ile Relu gösterme eğilimi daha iyi yakınsama performansı sigmoid.

Benzer şekilde, ReLU neden en iyi etkinleştirme işlevidir?

Ana fikir, eğimin sıfır olmamasına izin vermek ve sonunda eğitim sırasında iyileşmek. ReLu tanh'dan daha az hesaplama pahalıdır ve sigmoid çünkü daha basit matematiksel işlemleri içerir. Bu bir iyi derin sinir ağları tasarlarken göz önünde bulundurmamız gereken nokta.

Ayrıca sigmoid aktivasyon fonksiyonu nedir diye de sorulabilir. NS sigmoid işlevi bir aktivasyon fonksiyonu Sinir Ağlarında, Nöronların ateşlenmesiyle ilişkili olarak yapılandırılmış temel kapı açısından. Türev, aynı zamanda bir aktivasyon fonksiyonu Neuron'u ele alma açısından aktivasyon NN'ler açısından. İkisi arasındaki fark, aktivasyon derece ve etkileşim.

Benzer şekilde, CNN'de neden ReLU kullanıyoruz?

Evrişimli Sinir Ağları ( CNN ): Adım 1(b) - ReLU Katman. Rektifiye Doğrusal Birim veya ReLU , NS evrişimli sinir ağlarının sürecinin ayrı bir bileşeni değildir. Doğrultucu işlevini uygulamanın amacı NS görüntülerimizdeki doğrusal olmayanlığı artırmak için.

ReLU'nun kullanımı nedir?

ReLU (Rektifiyeli Doğrusal Birim) AktivasyonFonksiyonu ReLU en çok kullanılmış aktivasyon işlevi şu anda dünyada. kullanılmış neredeyse tüm evrişimli sinir ağlarında veya derin öğrenmede.

Önerilen:

Tumblr Instagram'dan daha mı iyi?

Tumblr, onu Instagram'dan daha çok yönlü yapan bir mikroblog sitesidir. Metin, resim, bağlantı, video ve izleyicileri heyecanlandırabilecek her şeyi paylaşmak için bu sosyal medya ağ kanalını kullanabilirsiniz. İşletmeler için Tumblrof, ürünlerini tanıtmanın daha özelleştirilmiş bir yolunu sunuyor

Daha iyi bir kamera mı yoksa daha iyi bir lens mi almalıyım?

Bence, finansal yatırımla ilgili olarak, iyi bir lens daha iyi bir seçim çünkü sizi vücuttan çok daha uzun süre dayanacak (çünkü genellikle kamera gövdelerini lenslerden daha hızlı değiştireceksiniz). Öte yandan, aynı lensler muhtemelen bundan beş ila 10 yıl sonra kullanılmaya devam edecek (daha da uzun olmasa bile)

Sky Q, Virgin Media'dan daha mı iyi?

Sky Q vs Virgin Media TiVo: Moretuners Virgin Media TiVo, yıllardır yalnızca Sky+ HD'den değil, aynı zamanda çoğu üçüncü taraf Freeview DVR'sinden daha fazla tuner sunuyor. Sky Q 2 TB kutusu, işleri daha da ileriye götürerek, üç TV'ye, iki tablete akış ve aynı anda dört kanalda kayıt için devasa bir 12 tuner sunar

GSON, Jackson'dan daha mı iyi?

'Jackson, GSON ve JSONSmart'tan sürekli olarak daha hızlıdır. Boon JSON ayrıştırıcısı ve yeni Groovy 2.3 JSON ayrıştırıcısı, Jackson'dan daha hızlıdır. InputStream, Reader, okuma dosyaları, byte[], char[] ve String ile daha hızlılar.'

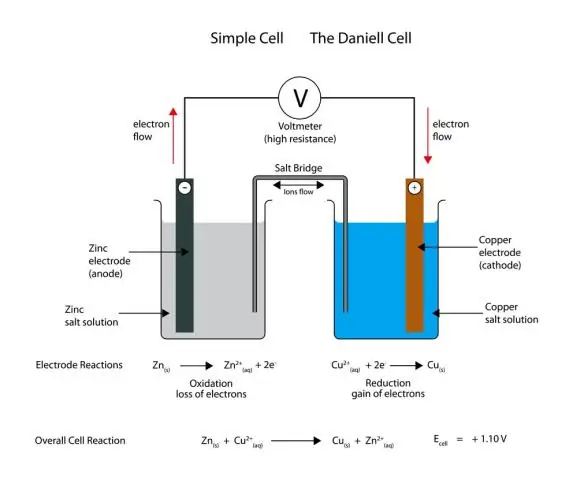

Bir pildeki daha fazla hücre daha mı iyi?

Diğer her şey eşit olduğunda, daha fazla hücre daha iyi. Bir pil ne kadar fazla hücreye sahipse, her pil şarjı o kadar uzun süre dayanır, dolayısıyla dizüstü bilgisayarın tek bir pil şarjıyla "çalışma süresi" o kadar uzun olur. Ve aynı derecede önemli olan, pilin kendisi genel olarak daha uzun ömürlü olacaktır