- Yazar Lynn Donovan [email protected].

- Public 2023-12-15 23:54.

- Son düzenleme 2025-01-22 17:44.

1) Küçük Dosya sorunu içinde HDFS : Çok fazla depolamak küçük dosyalar son derece daha küçük blok boyutu tarafından verimli bir şekilde ele alınamaz HDFS . baştan sona okuma küçük dosyalar Veri düğümü ile veri düğümü arasında çok sayıda arama ve çok sayıda atlama içerir, bu da verimsiz veri işleme anlamına gelir.

Bunun yanında, Hadoop'ta hangi dosyalar küçük dosya sorunlarıyla ilgileniyor?

1) HAR ( Hadoop Arşiv) Dosyalar tanıtıldı küçük dosya sorunu ile başa çıkmak . HAR, üzerine bir katman ekledi HDFS için arayüz sağlayan dosya erişim. kullanma Hadoop arşiv komutu, HAR Dosyalar çalıştıran oluşturulur Harita indirgeme paketleme işi Dosyalar arşivleniyor daha küçük sayısı HDFS dosyaları.

Ayrıca, HDFS'de farklı blok boyutları kullanan birden fazla dosyam olabilir mi? Varsayılan boy ile ilgili engellemek 64 MB'dir. sen Yapabilmek ihtiyacınıza göre değiştirin. sorunuza geliyorum evet birden fazla dosya oluşturabilir değişerek blok boyutları ama Gerçek Zamanlı olarak bu niyet üretimden yana değil.

Ayrıca, HDFS neden küçük dosyaları en iyi şekilde işlemez?

ile ilgili sorunlar küçük dosyalar ve HDFS Her dosya , dizin ve engelleme HDFS genel bir kural olarak, her biri 150 bayt kaplayan adenodun belleğinde bir nesne olarak temsil edilir. Üstelik, HDFS değil verimli bir şekilde erişmeye yönelik küçük dosyalar : o NS öncelikle büyük akışlı erişim için tasarlanmıştır Dosyalar.

Hadoop neden yavaş?

Yavaş İşlem Hızı Bu diskin aradığı zaman alır, böylece tüm süreci çok hızlı hale getirir. yavaş . Eğer Hadoop verileri küçük hacimli işler, çok yavaş karşılaştırmalı olarak. Büyük veri kümeleri için idealdir. Olarak Hadoop çekirdekte toplu işleme motoruna sahiptir, gerçek zamanlı işleme hızı daha düşüktür.

Önerilen:

TFS'de sorun nedir?

Sorun, bir iş öğesinin, onu sorunlu olabilecek diğer iş öğeleriyle gruplandırmanıza olanak tanıyan bir özelliğidir. Bir şeyi sorun olarak işaretlemek için, iş öğesini oluştururken bunu manuel olarak yapmanız gerekir

Hangisi aslında güvenlikle ilgili HTTP yanıt başlıklarını ayarlayan daha küçük bir ara katman yazılımı işlevleri topluluğudur?

Kask aslında yalnızca güvenlikle ilgili HTTP yanıt başlıklarını ayarlayan daha küçük bir ara katman yazılımı işlevleri topluluğudur: csp, Siteler arası komut dosyası çalıştırma saldırılarını ve diğer siteler arası enjeksiyonları önlemeye yardımcı olmak için İçerik-Güvenlik-İlkesi başlığını ayarlar

Etik sorun yoğunluğu nedir?

“Etik konu yoğunluğu, bir olayın veya kararın birey, çalışma grubu ve/veya kuruluş gözünde alaka düzeyi veya önemi olarak tanımlanabilir”[Fer14]

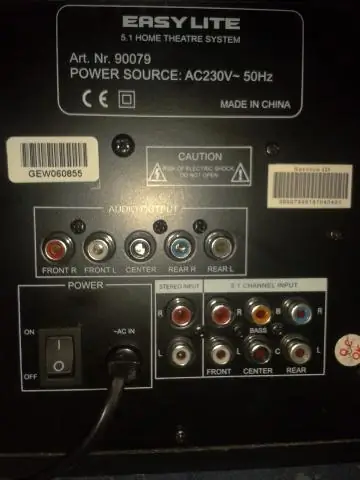

Bilgisayarımdaki sesimle ilgili sorun nedir?

Bilgisayarınızda ses çalma sorunları varsa, sorunu gidermek için Ses Çalma sorun gidericisini kullanmayı deneyin. Ses ayarlarınız, ses kartınız veya sürücünüz ve hoparlörleriniz veya kulaklıklarınız ile ilgili genel sorunları kontrol eder. Donanım ve Ses altında, Ses çalma sorunlarını gider'i tıklayın

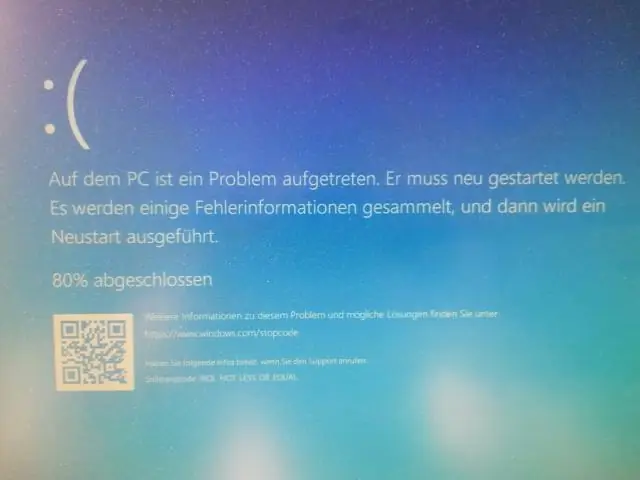

Sorun giderme süreci nedir?

Sorun giderme, genellikle bir makine veya sistemdeki arızalı ürünleri veya süreçleri onarmak için uygulanan bir sorun çözme biçimidir. Bir problemin kaynağını çözmek ve ürünü veya süreci tekrar işler hale getirmek için mantıklı, sistematik bir araştırmadır. Belirtileri belirlemek için sorun giderme gereklidir